Три закона робототехники Айзека Азимова, вероятно, являются самыми известными и влиятельными из когда-либо написанных в сайенс-фикшн строк в направлении технической политики. Известный писатель предположил, что по мере того, как машины будут обретать большую автономию и играть большую роль в жизни человека, нам понадобятся жёсткие правила, чтобы они не могли нанести нам вред.

Теперь, с A.I., автоматизацией и восходом заводской робототехники создаваемые машинами и их производителями опасности ещё более сложны и насущны. Специально к старту нового потока курса Machine Learning представляем вам перевод интервью с Фрэнком Паскуале, профессором Бруклинского юридического института, который в провокационной книге New Laws of Robotics: Defending Human Expertise in the Age of AI предлагает добавить четыре новых закона к трём законам Азимова.

Приводим законы Азимова для тех, кто с ними не знаком:

По словам Паскуале, мы должны пойти дальше. Он утверждает, что старые законы должны быть дополнены ещё четырьмя законами:

Новые законы проистекают из настойчивости Паскуале в его убеждении: прокол в робототехнике и искусственном интеллекте, а также роли технологий в обществе — в том, что не следует оставлять Силиконовую долину в одиночестве, чтобы она могла что-то диктовать. Если новые законы будут соблюдаться, говорит Паскуале, то можно будет использовать технологии для дополнения рабочих мест всех видов, а не для их захвата, особенно в секторах здравоохранения и образования. Однако для этого, по его мнению, директивные и регулирующие органы должны содействовать формированию и демократизации результатов работы в области ИИ. Сдерживание «автоматизации, которая контролирует, клеймит и обманывает невинных людей, — жизненно важная роль регуляторов XXI века», — пишет он. «Нам не просто нужно больше искусственного интеллекта, нам нужен искусственный интеллект лучше».

OneZero обратился к Паскуале, чтобы обсудить, почему он решил обновить законы Азимова, поговорить о причинах, лежащих в основе новых законов, и о многом другом.

Почему вы считаете важным обновить три закона Азимова? Кроме того, зачем делать акцент в книге вокруг демократизации этих решений о том, как используются робототехника и искусственный интеллект?

Законы Азимова — о том, чтобы роботы не обращались с людьми плохо. И я думаю, что это очень важно, конечно, но нам нужно больше идей, учитывающих настоящее и будущее, с которым мы столкнёмся. Намного больше. Нам необходимо обеспечить прочный и демократичный человеческий контроль над развитием технологий. Я думаю, большая мечта многих людей из области ИИ, предположительно, — просто позволить ИИ взять на себя работу врача, медсестры, журналиста, учителя и так далее. И моя идея заключается в том, что это в действительности не та цель, к которой мы должны стремиться. Верно? Главный вопрос — в том, должны ли мы вообще делать так. Думаю, нет. Надлежащая роль многих из этих технологических областей для меня — дополнять и поддерживать профессионалов, а не заменять их.

Вполне вероятно, что дискуссии вокруг А.I. можно переосмыслить таким образом и отойти от мысли, что роботы заберут у нас нашу работу?

Думаю, да. Я честен с вами. Возьмите медицину: 10 лет назад были люди, которые говорили: «Берегитесь, врачи, роботы идут. У них отличное распознавание образов и данные, они заменят вас». Эти же люди, в частности, говорили: «Если вы врач в области радиологии, анестезиологии, дерматологии и патологии… всё это просто распознавание образов, и робот или ИИ с доступом к миллионам изображений нормальных и больных тканей сделает вашу работу намного лучше, чем вы». Здесь возникает вопрос: «Откуда роботы берут данные?». Данные берутся от людей, и, может быть, в конце концов системы ИИ станут машинами, которые будут способны брать данные самостоятельно, но даже если бы машины могли делать это, они не заменят ни одного человека на рабочем месте. На самом деле машина дополняет человека во многих отношениях, и эта ситуация должна оставаться такой. Подумаем о дерматологе. Даже если у вас есть распознающее родинки приложение, вы всё равно захотите поговорить о них с реальным человеком. Вы спросите: «Насколько вероятно, что это ложное позитивное или ложное негативное срабатывание? Мы вырезаем эту родинку, или она комфортна для вас?». Вот пример критического решения, которое должны принимать люди.

Каковы ваши размышления о том, что стоит за каждым новым законом робототехники?

Видение этого очень широко. Будь моя воля, широта задач была бы сопоставима с чем-то вроде Нового курса, где, в сущности, имелся бы массив укоренявшихся десятилетиями агентств с законодательными уставами объёмом от пяти до ста или около того страниц. Затем возникли бы агентства, похожие на Агентство безопасности, Комиссию по ценным бумагам, Федеральную комиссию связи и другие, работающие над уточнением вышеупомянутых уставов. Я надеюсь, что это произойдёт с приходом новых законов робототехники, что придут независимые агентства, которые будут уполномочены применять эти идеи.

Можете привести пару конкретных примеров того, как некоторые из ваших законов будут работать на практике?

Конечно. Возьмите первый предложенный закон о профессиях и дополнении ИИ. Робот не должен быть сертифицирован как учитель. Можно разрешить роботов или ИИ в качестве технологии, которую учителя смогут прописывать точно так же, как врачи прописывают лекарства, но не нужно стремиться к тому, чтобы учителя или какое-либо сочетание онлайн-лекций отслеживалось и курировалось исключительно искусственным интеллектом. Не хочется, чтобы ИИ действительно заменил учителей. Это пример работы закона о комплементарности в работе.

Второй новый закон «Не подделывать человека» требует, чтобы, к примеру, любой находящийся в сети робот был чётко обозначен как таковой. А для введения четвёртого нового закона в отношении атрибуции необходимо, чтобы бот был приписан конкретному лицу. На самом деле пример ботов хорош даже для третьего нового закона, здесь можно сказать, что по мере того, как эти боты начинают распространяться из-за попыток привлечь человеческое внимание в Интернете, можно принять некоторые законодательные или административные меры, чтобы остановить эту гонку вооружений между ботами за человеческое внимание.

Ваш третий новый закон направлен на предотвращение усиления гонки вооружений. Он не ограничивается военными вопросами, верно?

Верно. Я думаю, что есть много областей жизни, где мы контролируем технологию и где крупные технологические фирмы используют ИИ для получения прибыли, ставя людей в условия крысиных бегов. Я долгое время писал о рейтингах и рангах, и я думаю, что кредитный скоринг был ранним примером этого явления. А с алгоритмическим кредитованием это явление приобретает большую интенсивность. Мы увидим всё больше и больше кредиторов, применяющих ИИ и говорящих: «Мы могли бы дать вам скидку на ипотеку в 1 %, но нам нужно увидеть всю историю вызовов в вашем телефоне». Или: «Нам просто нужно увидеть больше данных о вас». Или: «Мы дадим вам скидку на вашу медицинскую страховку, вы просто должны носить это устройство, которое использует ИИ, чтобы „вычислить“, насколько вы здоровы». Эта постоянная жажда всё новых и новых данных сама по себе — гонка вооружений между технологическими компаниями. Эта жажда устраивает гонку вооружений между людьми, где они пытаются давать всё больше и больше данных, чтобы отличать себя от других. Поэтому помните, что всякий раз, когда вам дают скидку из-за вашего поведения или чего-то в этом роде, кто-то, вероятно, платит больше, верно? Такое компанией делается не по доброте душевной.

Не могли бы вы пояснить закон о том, что ИИ и робототехника должны направлять к своим создателям? Почему это так важно?

Закон вводится, по сути, для того, чтобы остановить даже идею или стремление ИИ быть автономным от людей. Я имею в виду, что существуют научно-фантастические или футуристические устремления к созданию роботов, которые могли бы быть похожими, скажем, на ваших детей. Мы обучали бы их, пока они молоды, а потом отправляли в мир. Представьте себе робота в фильме Ex Machina, Ava, её просто неконтролируемый выход в мир и так далее. Такого не должно случиться никогда. Любой выпущенный в мир робот или любой участвующий в сети как бот ИИ — все они должны отслеживаться до их владельца или контролёра, который может в любой момент отключить их или иным образом изменить их поведение, то есть робот не должен быть автономным. Мы просто избавляемся от идеи автономности. Вычёркиваем ее как то, чего никогда не сделаем.

Скажу о причине, по которой я думаю, что это важно. Я беспокоюсь вот о чём. Представьте, что мы живём в мире, где тротуарные роботы или беспилотники, другие вещи могут приближаться к нам, и мы не знаем, что они делают или почему они это делают. Я думаю, что всякий раз, когда к вам приближается беспилотник или тротуарный робот, вы должны быть в состоянии направить на него свой мобильный телефон и сразу же получить информацию: «Вот владелец, а вот кто-то, на кого вы можете пожаловаться». Это как уведомление об авторском праве на сайте в цифровую эпоху. Другими словами, речь идет о соответствующем органе управления, в который вы можете обратиться с жалобой, если владелец не отвечает на ваши беспокойства.

Какая ответственность лежит на создателях за то, что в итоге делают роботы и ИИ?

Для занятых в областях робототехники и искусственного интеллекта людей пришло время взять ответственность за невероятную гибкость и пластичность их ПО, которое можно было бы запрограммировать иначе. Возьмём такой пример: я не должен расстраиваться или сочувствовать плачущему роботу, потому что его можно так же легко запрограммировать смеяться над всем, что заставляет его искусственно плакать. И здесь мы должны быть трезвыми, поскольку существует быстрорастущая область аффективных вычислений, которая для меня во многих отношениях — прелюдия к манипулированию людьми и контролю над ними со стороны крупных корпораций и правительств через посреднические эффекты технологий. И мы должны смотреть этим мрачным возможностям прямо в глаза.

В книге вы в основном концентрируетесь на влиянии ИИ и автоматизации на «профессиональную» работу. А как насчёт синих воротничков? Или людей, которые работают, скажем, на складе или в качестве кассиров в продуктовом магазине?

Об этом стоит сказать. И это так интересно, когда думаешь о работе кассира, потому что, когда есть автоматизированные киоски, которые проверяют людей, и один человек смотрит за тремя-четырьмя киосками, можно сказать: «Роботы лишили работы четырёх человек». Или можно сказать: «Ну, это позволило одному человеку быть более продуктивным, потому что теперь он отвечает за эти машины, пропускающие людей, пытается их починить, убедиться, что машины работают эффективно и так далее». Это будет очень интересный вопрос, но, в конечном счёте, я не думаю, что в этом вопросе политика должна стоять на пути автоматизации, если только люди работающие кассиры не скажут: «Есть причина, по которой вам нужны человеческое суждение и люди, которые контролируют процесс». И если убрать нас из процесса, возникнет большая проблема».

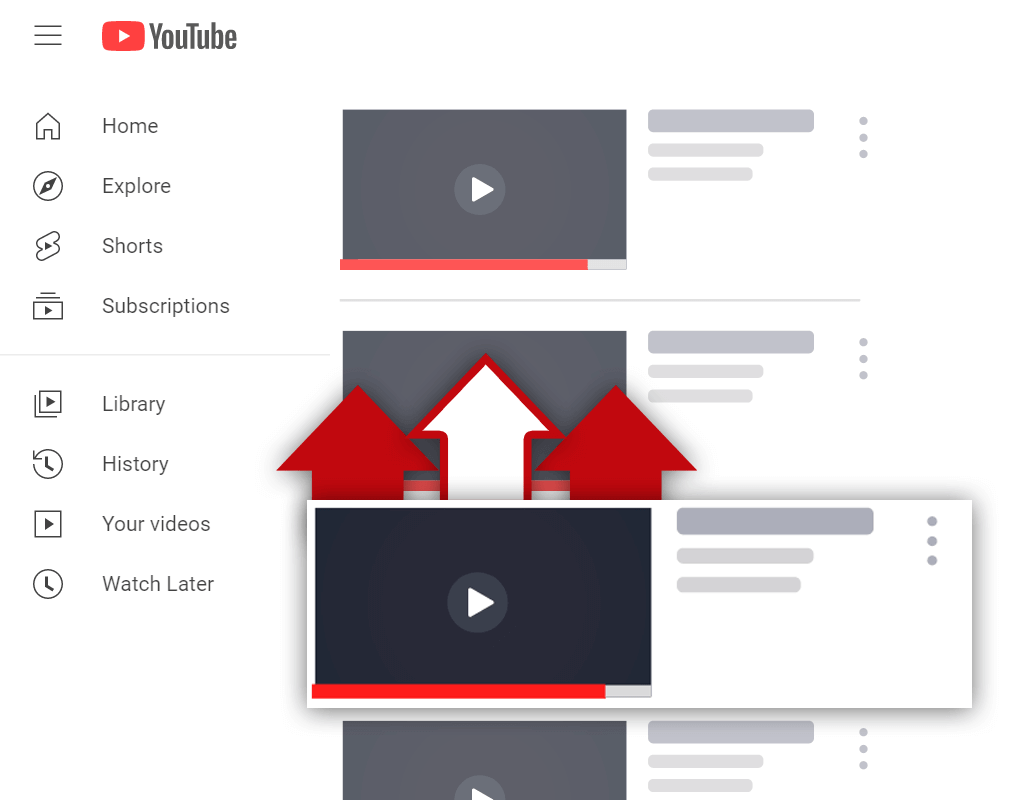

В вашей предыдущей книге The Black Box Society: The Secret Algorithms That Control Money and Information вы скрупулёзно изучаете, как подобные YouTube или Facebook-платформы процветают с помощью алгоритмов, задерживающих нас на сайте через предложение контента, в значительной степени основанного на том, что мы уже посмотрели. И, как мы все уже видели, это часто заканчивается поощрением и распространением дезинформации и теорий заговора. На ваш взгляд, нужно ли больше регулирования для решения этой проблемы?

Абсолютно необходимо. Во-первых, в новой книге я рассматриваю проблему управляющего медиа ИИ, берущего на себя главным образом редакторские функции и даже иногда функции по созданию распространяемого контента. Это вызывает тревогу, поскольку такие системы оптимизированы под задачу грубым, упрощённым образом, они сырые и не отражают социальную ценность истины. И, как вы уже упомянули, сильно проявили себя теории заговора. Попасть в ряды их сторонников легко. Другая проблема заключается в том, что управляемые ИИ платформы скажут в ответ: «Мы просто даём людям то, что они хотят». На самом же деле то, как разработана архитектура самого выбора, имеет большое влияние на то, чего хотят люди. Мы не должны жить в мире, где ИИ может сказать: «Хорошо, мы получим еще 10 зрителей, если покажем эти сумасшедшие педофильные клипы или ещё что-нибудь». Это просто грубый путь к высоким метрикам успеха.

Что, по-вашему, заставляет нас хотеть создавать роботов и ИИ, которые очень похожи на нас?

Основные аргументы в пользу создания роботов, похожих на людей, исходят из постгуманистической или трансгуманистической перспективы. Сторонник постчеловеческий перспективы сказал бы: “Мы хорошо поработали на Земле, но, вы знаете, в конечном счёте наш мозг слишком медленный. Роботы оснащены более производительными процессорами. Они будут понимать и делать больше в этом мире. Просто позвольте им это. И трансгуманист скажет: «Да, если вы хотите выйти за пределы человеческих ограничений, вам, наверное, придётся выйти за пределы человеческого тела». И часть такого подхода — вход в робототехнику, слияние с ней или что-то в этом роде. И я считаю, что трансгуманистические и постгуманистические перспективы, в конечном счете, очень антигуманистичны.

В чем конкретно эти позиции антигуманнны?

Отчасти существенным элементом человеческой сущности являются принятие и понимание наших ограничений. Наши слабости. Нужно усилие, чтобы превзойти слабость и сказать: «Ну, вот бессмертное существо; давайте относиться к нему, как к сверхчеловеку». Это проблематично. Такой подход включает отрицание того факта, что мы смертны. Что мы чувствуем боль. У нас есть ограниченное количество вещей, на которые мы можем потратить наше внимание. Когда я умру, накопится миллиард не прочитанных мной книг. И я не думаю, что кто-то может сказать: «Ну, представьте себе, вы были бы намного лучше — если бы вы были роботом, который мог бы обрабатывать 1 миллион книг за короткое время». Мой короткий ответ на это: я не думаю, что такое было бы похоже на ситуацию, когда я по-человечески читаю книгу или когда любой другой человек читает. Есть уникальный способ, которым мы взаимодействуем с вещами, и это делает нас особенными.

В целом что больше всего мотивировало на конфронтацию с возникающим ИИ в книге?

Я на самом деле хотел исследовать, что это значит — ставить человеческий труд в центр экономики и общества. В противопоставление подходу, когда человеческий труд — просто ресурс, подобный природному, где человек просто кладёт вещи в некую машину и следит за тем, что делает машина, получая на выходе нечто. Эти поиски действительно важны, в частности потому, что наша экономика сейчас ориентирована на такие вещи, как финансовые активы, акции — и на владельца этих вещей, и именно так мы измеряем успех во многих отношениях: мы смотрим, поднимается или опускается фондовый рынок. И вот мой вопрос: «Как мы могли бы думать о будущем технологий и работать над тем, чтобы человеческий труд был в центре всей дискуссии?». И размышления об этом, я надеюсь, дают представление о том, как экономика может быть намного справедливее и стабильнее для нас, людей.

Теперь, с A.I., автоматизацией и восходом заводской робототехники создаваемые машинами и их производителями опасности ещё более сложны и насущны. Специально к старту нового потока курса Machine Learning представляем вам перевод интервью с Фрэнком Паскуале, профессором Бруклинского юридического института, который в провокационной книге New Laws of Robotics: Defending Human Expertise in the Age of AI предлагает добавить четыре новых закона к трём законам Азимова.

Приводим законы Азимова для тех, кто с ними не знаком:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат первому закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первому или второму законам.

По словам Паскуале, мы должны пойти дальше. Он утверждает, что старые законы должны быть дополнены ещё четырьмя законами:

- Цифровые технологии должны дополнять профессионалов, а не заменять их.

- ИИ и роботизированные системы не должны подделывать человека.

- В области ИИ следует предотвратить усиление гонок вооружения с нулевой суммой [прим. перев. — это относится к понятию игр с нулевой суммой из теории игр].

- Роботы и системы ИИ должны указывать на личность своих создателей, контролирующих их людей и владельцев.

Новые законы проистекают из настойчивости Паскуале в его убеждении: прокол в робототехнике и искусственном интеллекте, а также роли технологий в обществе — в том, что не следует оставлять Силиконовую долину в одиночестве, чтобы она могла что-то диктовать. Если новые законы будут соблюдаться, говорит Паскуале, то можно будет использовать технологии для дополнения рабочих мест всех видов, а не для их захвата, особенно в секторах здравоохранения и образования. Однако для этого, по его мнению, директивные и регулирующие органы должны содействовать формированию и демократизации результатов работы в области ИИ. Сдерживание «автоматизации, которая контролирует, клеймит и обманывает невинных людей, — жизненно важная роль регуляторов XXI века», — пишет он. «Нам не просто нужно больше искусственного интеллекта, нам нужен искусственный интеллект лучше».

OneZero обратился к Паскуале, чтобы обсудить, почему он решил обновить законы Азимова, поговорить о причинах, лежащих в основе новых законов, и о многом другом.

Почему вы считаете важным обновить три закона Азимова? Кроме того, зачем делать акцент в книге вокруг демократизации этих решений о том, как используются робототехника и искусственный интеллект?

Законы Азимова — о том, чтобы роботы не обращались с людьми плохо. И я думаю, что это очень важно, конечно, но нам нужно больше идей, учитывающих настоящее и будущее, с которым мы столкнёмся. Намного больше. Нам необходимо обеспечить прочный и демократичный человеческий контроль над развитием технологий. Я думаю, большая мечта многих людей из области ИИ, предположительно, — просто позволить ИИ взять на себя работу врача, медсестры, журналиста, учителя и так далее. И моя идея заключается в том, что это в действительности не та цель, к которой мы должны стремиться. Верно? Главный вопрос — в том, должны ли мы вообще делать так. Думаю, нет. Надлежащая роль многих из этих технологических областей для меня — дополнять и поддерживать профессионалов, а не заменять их.

Вполне вероятно, что дискуссии вокруг А.I. можно переосмыслить таким образом и отойти от мысли, что роботы заберут у нас нашу работу?

Думаю, да. Я честен с вами. Возьмите медицину: 10 лет назад были люди, которые говорили: «Берегитесь, врачи, роботы идут. У них отличное распознавание образов и данные, они заменят вас». Эти же люди, в частности, говорили: «Если вы врач в области радиологии, анестезиологии, дерматологии и патологии… всё это просто распознавание образов, и робот или ИИ с доступом к миллионам изображений нормальных и больных тканей сделает вашу работу намного лучше, чем вы». Здесь возникает вопрос: «Откуда роботы берут данные?». Данные берутся от людей, и, может быть, в конце концов системы ИИ станут машинами, которые будут способны брать данные самостоятельно, но даже если бы машины могли делать это, они не заменят ни одного человека на рабочем месте. На самом деле машина дополняет человека во многих отношениях, и эта ситуация должна оставаться такой. Подумаем о дерматологе. Даже если у вас есть распознающее родинки приложение, вы всё равно захотите поговорить о них с реальным человеком. Вы спросите: «Насколько вероятно, что это ложное позитивное или ложное негативное срабатывание? Мы вырезаем эту родинку, или она комфортна для вас?». Вот пример критического решения, которое должны принимать люди.

Каковы ваши размышления о том, что стоит за каждым новым законом робототехники?

Видение этого очень широко. Будь моя воля, широта задач была бы сопоставима с чем-то вроде Нового курса, где, в сущности, имелся бы массив укоренявшихся десятилетиями агентств с законодательными уставами объёмом от пяти до ста или около того страниц. Затем возникли бы агентства, похожие на Агентство безопасности, Комиссию по ценным бумагам, Федеральную комиссию связи и другие, работающие над уточнением вышеупомянутых уставов. Я надеюсь, что это произойдёт с приходом новых законов робототехники, что придут независимые агентства, которые будут уполномочены применять эти идеи.

Можете привести пару конкретных примеров того, как некоторые из ваших законов будут работать на практике?

Конечно. Возьмите первый предложенный закон о профессиях и дополнении ИИ. Робот не должен быть сертифицирован как учитель. Можно разрешить роботов или ИИ в качестве технологии, которую учителя смогут прописывать точно так же, как врачи прописывают лекарства, но не нужно стремиться к тому, чтобы учителя или какое-либо сочетание онлайн-лекций отслеживалось и курировалось исключительно искусственным интеллектом. Не хочется, чтобы ИИ действительно заменил учителей. Это пример работы закона о комплементарности в работе.

Второй новый закон «Не подделывать человека» требует, чтобы, к примеру, любой находящийся в сети робот был чётко обозначен как таковой. А для введения четвёртого нового закона в отношении атрибуции необходимо, чтобы бот был приписан конкретному лицу. На самом деле пример ботов хорош даже для третьего нового закона, здесь можно сказать, что по мере того, как эти боты начинают распространяться из-за попыток привлечь человеческое внимание в Интернете, можно принять некоторые законодательные или административные меры, чтобы остановить эту гонку вооружений между ботами за человеческое внимание.

Ваш третий новый закон направлен на предотвращение усиления гонки вооружений. Он не ограничивается военными вопросами, верно?

Верно. Я думаю, что есть много областей жизни, где мы контролируем технологию и где крупные технологические фирмы используют ИИ для получения прибыли, ставя людей в условия крысиных бегов. Я долгое время писал о рейтингах и рангах, и я думаю, что кредитный скоринг был ранним примером этого явления. А с алгоритмическим кредитованием это явление приобретает большую интенсивность. Мы увидим всё больше и больше кредиторов, применяющих ИИ и говорящих: «Мы могли бы дать вам скидку на ипотеку в 1 %, но нам нужно увидеть всю историю вызовов в вашем телефоне». Или: «Нам просто нужно увидеть больше данных о вас». Или: «Мы дадим вам скидку на вашу медицинскую страховку, вы просто должны носить это устройство, которое использует ИИ, чтобы „вычислить“, насколько вы здоровы». Эта постоянная жажда всё новых и новых данных сама по себе — гонка вооружений между технологическими компаниями. Эта жажда устраивает гонку вооружений между людьми, где они пытаются давать всё больше и больше данных, чтобы отличать себя от других. Поэтому помните, что всякий раз, когда вам дают скидку из-за вашего поведения или чего-то в этом роде, кто-то, вероятно, платит больше, верно? Такое компанией делается не по доброте душевной.

Не могли бы вы пояснить закон о том, что ИИ и робототехника должны направлять к своим создателям? Почему это так важно?

Закон вводится, по сути, для того, чтобы остановить даже идею или стремление ИИ быть автономным от людей. Я имею в виду, что существуют научно-фантастические или футуристические устремления к созданию роботов, которые могли бы быть похожими, скажем, на ваших детей. Мы обучали бы их, пока они молоды, а потом отправляли в мир. Представьте себе робота в фильме Ex Machina, Ava, её просто неконтролируемый выход в мир и так далее. Такого не должно случиться никогда. Любой выпущенный в мир робот или любой участвующий в сети как бот ИИ — все они должны отслеживаться до их владельца или контролёра, который может в любой момент отключить их или иным образом изменить их поведение, то есть робот не должен быть автономным. Мы просто избавляемся от идеи автономности. Вычёркиваем ее как то, чего никогда не сделаем.

Скажу о причине, по которой я думаю, что это важно. Я беспокоюсь вот о чём. Представьте, что мы живём в мире, где тротуарные роботы или беспилотники, другие вещи могут приближаться к нам, и мы не знаем, что они делают или почему они это делают. Я думаю, что всякий раз, когда к вам приближается беспилотник или тротуарный робот, вы должны быть в состоянии направить на него свой мобильный телефон и сразу же получить информацию: «Вот владелец, а вот кто-то, на кого вы можете пожаловаться». Это как уведомление об авторском праве на сайте в цифровую эпоху. Другими словами, речь идет о соответствующем органе управления, в который вы можете обратиться с жалобой, если владелец не отвечает на ваши беспокойства.

Какая ответственность лежит на создателях за то, что в итоге делают роботы и ИИ?

Для занятых в областях робототехники и искусственного интеллекта людей пришло время взять ответственность за невероятную гибкость и пластичность их ПО, которое можно было бы запрограммировать иначе. Возьмём такой пример: я не должен расстраиваться или сочувствовать плачущему роботу, потому что его можно так же легко запрограммировать смеяться над всем, что заставляет его искусственно плакать. И здесь мы должны быть трезвыми, поскольку существует быстрорастущая область аффективных вычислений, которая для меня во многих отношениях — прелюдия к манипулированию людьми и контролю над ними со стороны крупных корпораций и правительств через посреднические эффекты технологий. И мы должны смотреть этим мрачным возможностям прямо в глаза.

В книге вы в основном концентрируетесь на влиянии ИИ и автоматизации на «профессиональную» работу. А как насчёт синих воротничков? Или людей, которые работают, скажем, на складе или в качестве кассиров в продуктовом магазине?

Об этом стоит сказать. И это так интересно, когда думаешь о работе кассира, потому что, когда есть автоматизированные киоски, которые проверяют людей, и один человек смотрит за тремя-четырьмя киосками, можно сказать: «Роботы лишили работы четырёх человек». Или можно сказать: «Ну, это позволило одному человеку быть более продуктивным, потому что теперь он отвечает за эти машины, пропускающие людей, пытается их починить, убедиться, что машины работают эффективно и так далее». Это будет очень интересный вопрос, но, в конечном счёте, я не думаю, что в этом вопросе политика должна стоять на пути автоматизации, если только люди работающие кассиры не скажут: «Есть причина, по которой вам нужны человеческое суждение и люди, которые контролируют процесс». И если убрать нас из процесса, возникнет большая проблема».

В вашей предыдущей книге The Black Box Society: The Secret Algorithms That Control Money and Information вы скрупулёзно изучаете, как подобные YouTube или Facebook-платформы процветают с помощью алгоритмов, задерживающих нас на сайте через предложение контента, в значительной степени основанного на том, что мы уже посмотрели. И, как мы все уже видели, это часто заканчивается поощрением и распространением дезинформации и теорий заговора. На ваш взгляд, нужно ли больше регулирования для решения этой проблемы?

Абсолютно необходимо. Во-первых, в новой книге я рассматриваю проблему управляющего медиа ИИ, берущего на себя главным образом редакторские функции и даже иногда функции по созданию распространяемого контента. Это вызывает тревогу, поскольку такие системы оптимизированы под задачу грубым, упрощённым образом, они сырые и не отражают социальную ценность истины. И, как вы уже упомянули, сильно проявили себя теории заговора. Попасть в ряды их сторонников легко. Другая проблема заключается в том, что управляемые ИИ платформы скажут в ответ: «Мы просто даём людям то, что они хотят». На самом же деле то, как разработана архитектура самого выбора, имеет большое влияние на то, чего хотят люди. Мы не должны жить в мире, где ИИ может сказать: «Хорошо, мы получим еще 10 зрителей, если покажем эти сумасшедшие педофильные клипы или ещё что-нибудь». Это просто грубый путь к высоким метрикам успеха.

Что, по-вашему, заставляет нас хотеть создавать роботов и ИИ, которые очень похожи на нас?

Основные аргументы в пользу создания роботов, похожих на людей, исходят из постгуманистической или трансгуманистической перспективы. Сторонник постчеловеческий перспективы сказал бы: “Мы хорошо поработали на Земле, но, вы знаете, в конечном счёте наш мозг слишком медленный. Роботы оснащены более производительными процессорами. Они будут понимать и делать больше в этом мире. Просто позвольте им это. И трансгуманист скажет: «Да, если вы хотите выйти за пределы человеческих ограничений, вам, наверное, придётся выйти за пределы человеческого тела». И часть такого подхода — вход в робототехнику, слияние с ней или что-то в этом роде. И я считаю, что трансгуманистические и постгуманистические перспективы, в конечном счете, очень антигуманистичны.

В чем конкретно эти позиции антигуманнны?

Отчасти существенным элементом человеческой сущности являются принятие и понимание наших ограничений. Наши слабости. Нужно усилие, чтобы превзойти слабость и сказать: «Ну, вот бессмертное существо; давайте относиться к нему, как к сверхчеловеку». Это проблематично. Такой подход включает отрицание того факта, что мы смертны. Что мы чувствуем боль. У нас есть ограниченное количество вещей, на которые мы можем потратить наше внимание. Когда я умру, накопится миллиард не прочитанных мной книг. И я не думаю, что кто-то может сказать: «Ну, представьте себе, вы были бы намного лучше — если бы вы были роботом, который мог бы обрабатывать 1 миллион книг за короткое время». Мой короткий ответ на это: я не думаю, что такое было бы похоже на ситуацию, когда я по-человечески читаю книгу или когда любой другой человек читает. Есть уникальный способ, которым мы взаимодействуем с вещами, и это делает нас особенными.

В целом что больше всего мотивировало на конфронтацию с возникающим ИИ в книге?

Я на самом деле хотел исследовать, что это значит — ставить человеческий труд в центр экономики и общества. В противопоставление подходу, когда человеческий труд — просто ресурс, подобный природному, где человек просто кладёт вещи в некую машину и следит за тем, что делает машина, получая на выходе нечто. Эти поиски действительно важны, в частности потому, что наша экономика сейчас ориентирована на такие вещи, как финансовые активы, акции — и на владельца этих вещей, и именно так мы измеряем успех во многих отношениях: мы смотрим, поднимается или опускается фондовый рынок. И вот мой вопрос: «Как мы могли бы думать о будущем технологий и работать над тем, чтобы человеческий труд был в центре всей дискуссии?». И размышления об этом, я надеюсь, дают представление о том, как экономика может быть намного справедливее и стабильнее для нас, людей.

- Продвинутый курс «Machine Learning Pro + Deep Learning»

- Курс «Математика и Machine Learning для Data Science»

- Курс по Machine Learning

- Обучение профессии Data Science

- Обучение профессии Data Analyst

- Курс «Python для веб-разработки»

Eще курсы

Рекомендуемые статьи

- Сколько зарабатывает дата-сайентист: обзор зарплат и вакансий в 2020

- Сколько зарабатывает аналитик данных: обзор зарплат и вакансий в 2020

- Как стать Data Scientist без онлайн-курсов

- 450 бесплатных курсов от Лиги Плюща

- Как изучать Machine Learning 5 дней в неделю 9 месяцев подряд

- Machine Learning и Computer Vision в добывающей промышленности